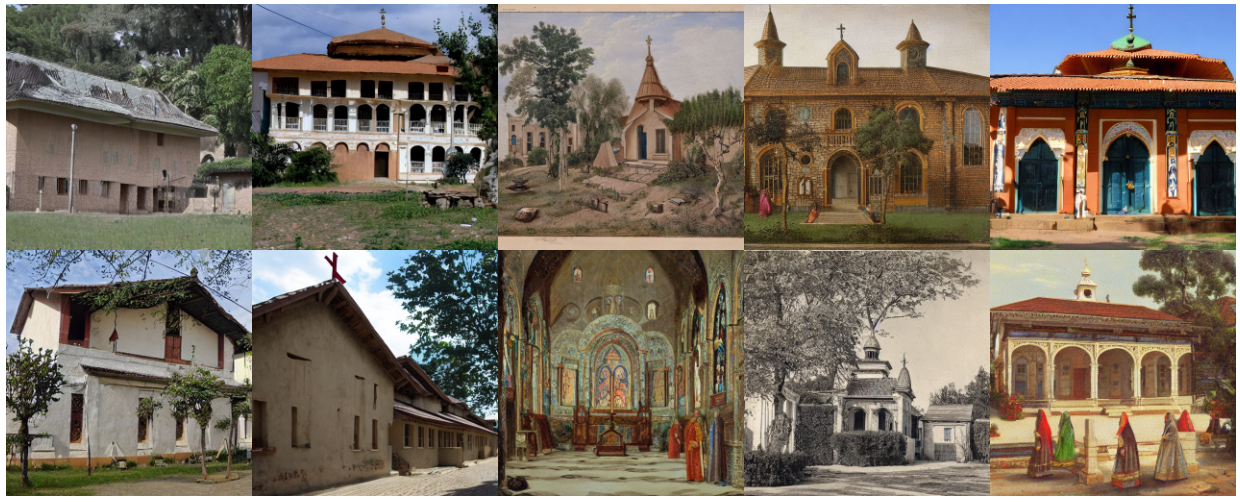

Aktuelle Modelle zur Generierung synthetischer Bilder aus Texteingaben sind nicht nur in der Lage, sehr realistisch aussehende Fotos zu erzeugen, sondern auch eine große Anzahl unterschiedlicher Objekte zu verarbeiten. In einem Report “Evaluating a Synthetic Image Dataset Generated with Stable Diffusion” (https://arxiv.org/abs/2211.01777) untersuche ich anhand des Modells “Stable Diffusion”, welche Objekte und Typen so realistisch dargestellt werden, dass eine anschließende Bildklassifikation diese korrekt zuordnet. Damit erhalten wir eine Bewertung des Modells hinsichtlich der realistischen Darstellung.

Es wurden 262,040 Bilder für 28,204 verschiedene Objekte erzeugt, indem mit einer Definition für das Objekt jeweils 10 Bilder erzeugt wurden. Die Definition stammt für alle Objekte aus der “Wordnet” Datenbank. Ein Beispiel einer solchen Definition (für Hunde) ist:

“a member of the genus Canis (probably descended from the common wolf) that has been domesticated by man since prehistoric times; occurs in many breeds”

Die so entstandene Bilddatenbank ist unter: https://www.kaggle.com/datasets/astoeckl/stable-diffusion-wordnet-dataset verfügbar.

Für eine Testmenge der gesamten Bilddatenbank wurde für die Mehrheit der Klassen (73 %) mindestens ein richtig erkanntes Bild generiert, aber nur für 14 % der Klassen alle 10 Bilder erkannt.

Mehr unter: